Spis treści:

ScrapeBox Automator to płatny plugin do automatyzowania pewnych zadań w ScrapeBoxie. Nie trzeba już czekać aż jedno zadanie zostanie wykonane, żeby uruchomić ręcznie kolejne. Plugin Automator sprawdza czy zadanie jest ukończone i jeżeli zwróci wartość true, to przechodzi do kolejnego zadania w naszym harmonogramie. Dzięki temu jesteśmy w stanie zautomatyzować wiele zadań, a następnie je odpalić – każde zadanie z listy zostanie uruchomione. Chyba nie muszę mówić ile czasu dzięki temu pluginowi zaoszczędzimy ? Czasy kiedy wykonywało się ręcznie każde zadanie w SB minęły.

ScrapeBox Automator to płatny plugin do automatyzowania pewnych zadań w ScrapeBoxie. Nie trzeba już czekać aż jedno zadanie zostanie wykonane, żeby uruchomić ręcznie kolejne. Plugin Automator sprawdza czy zadanie jest ukończone i jeżeli zwróci wartość true, to przechodzi do kolejnego zadania w naszym harmonogramie. Dzięki temu jesteśmy w stanie zautomatyzować wiele zadań, a następnie je odpalić – każde zadanie z listy zostanie uruchomione. Chyba nie muszę mówić ile czasu dzięki temu pluginowi zaoszczędzimy ? Czasy kiedy wykonywało się ręcznie każde zadanie w SB minęły.

Zalety pluginu Automator

- Możliwość zapisania zadań do pliku.

- Możliwość wczytania zadań do edycji (dodawanie nowych zadań, usuwanie zadań, zmiana kolejności wykonywanych zadań).

- Automatyzowanie wielu zadań.

- Cena tylko 20$.

Obsługiwane zadania w pluginie

- Użyj Proxy (Use Proxies)

– korzystanie z proxy (Check the „Use Proxies” checkbox) – jeżeli zaznaczymy ten parametr, to włączymy tym samym proxy

– usuń proxy według szybkości (Remove proxies with following detected speed) – tutaj mamy 3 opcje: 1. Wolne – więcej jak 300ms (Slow proxies – more than 3000ms), 2. Średnie – między 1501 i 3000ms (Medium proxies – between 1501 and 3000ms), 3. Szybkie – mniejsze lub równe 1500ms (Fast proxies – less or equal 1500ms) - Harvester Proxy (Harvest Proxies)

– Zastąp aktualną listę proxy (Replace current list) – kasuje wszystkie proxy, które posiadamy w boxie „Proxies” i zastępuje je nowymi - Załaduj proxy z pliku (Load proxies from file)

– Ścieżka do pliku (Proxy file) – wskazujemy ścieżkę do naszego pliku tekstowego z proxy - Test Proxy (Test Proxies)

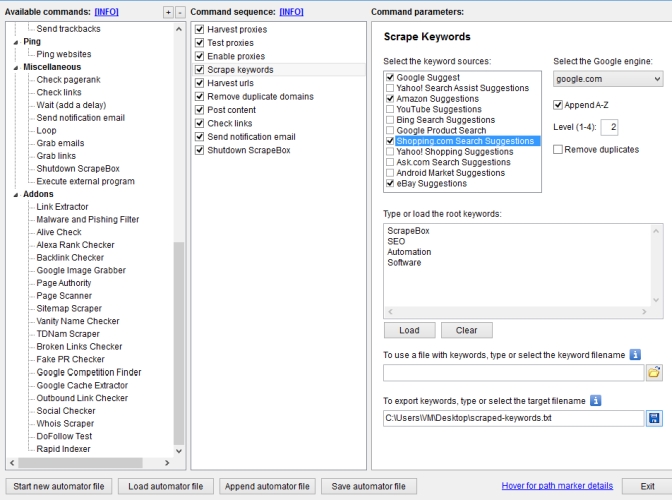

– Test proxy w Google (Test proxies also against Google) – jeżeli zaznaczymy ten parametr, to będziemy testowali nasze proxy w Google - Harvester słów kluczowych (Harvest keywords)

– Wybór źródła pobierania słów kluczowych (Select the keyword sources) – możemy zaznaczyć skąd mają być pobierane słowa kluczowe: sugestie wyszukiwań Google, sugestie wyszukiwań Yahoo, sugestie z Amazon, sugestie z YouTube, sugestie wyszukiwań Bing, wyszukiwarka produktów Google, sugestie wyszukiwań z shopping.com, sugestie ze sklepu Yahoo, sugestie wyszukiwań Ask.com

– Możliwość usunięcia zdublowanych słów kluczowych (Remove duplicate keywords)

– Ustawianie „głębokości” wyszukiwania (Select depth of search) – możemy ustawić „głębokość” od 1 do 4 - Harvester adresów URL (Harvest urls)

– Zaznaczenie wyszukiwarek internetowych (select the search engines below) – mamy możliwość zaznaczenia z jakich wyszukiwarek internetowych mają być pobierane adresy URL. Możemy wybrać: Google, Yahoo, Bing oraz AOL

– Podanie pojedynczego Footprintu (Enter a footprint (or leave blank)) – możemy podać jeden footprint lub nie wypełniać pola

– Wybór konkretnego „śladu” (Select a predefined footprint) – jeżeli mamy swoje własne footprinty, to wybieramy checkboxa: Custom i wklejamy nasze footprinty. Możemy też zaimportować nasze footprinty lub słowa kluczowe za pomocą przycisku: Import. Mamy jeszcze wybór harvestowania takich platform jak: WordPress, BlogEngine, Movable Type. Jeżeli zaznaczymy, któryś z tych checkboxów, to w miejsce boksu dla własnych footprintów wklejamy słowa kluczowe, lub zostawiamy puste pole, o ile wcześnie dodaliśmy i skonfigurowaliśmy zadanie odpowiedzialne za harvestowanie słów kluczowych

– Wybór pliku tekstowego zawierającego słowa kluczowe (Select a keyword file to use (ignore typed keywords above)) – jeżeli wybierzemy plik ze słowami kluczowymi, to zostaną zignorowane słowa w boksie powyżej

– Liczba wyników (Number of results) – tutaj podajemy liczbę od 1-1000. Jeżeli wpiszemy 1000, to zostanie pobrane 1000 wyników z wyszukiwarki na dany footprint. Oczywiście musi być taka ilość wyników na dany footprint, bo inaczej zostanie pobrana mniejsza ilość :)

– Eksport pobranych wyników do pliku tekstowego (Export harvested urls as:) – wybieramy plik tekstowych, w którym zostaną zapisane wyniki

– Scalanie footprintów ze słowami kluczowymi (Footprint List to merge with keywords) – jeżeli nie wiesz do czego służy w ScrapeBoxie przycisk „M” i co oznacza %KW%, to przeczytaj ten artykuł: https://pawelmacur.com/scrapebox-%E2%80%93-wskazowka-2/ - Usuwanie adresów URL, które zawierają określone ciągi znaków (Remove urls containing)

- Usuwanie adresów URL, które nie zawierają określonych ciągów znaków (Remove urls not containing)

- Usuwanie zduplikowanych adresów URL (Remove duplicates)

– Usuń zduplikowane adresy URL (Remove duplicate urls)

– Usuń zduplikowane domeny (Remove duplicate domains) - Wyczyszczenie pobranych adresów URL (Clear harvested urls)

- Wyczyszczenie footprintów (Clear footprints)

- Wyczyszczenie słów kluczowych (Clear keywords)

- Przenoszenie pobranych adresów URL (Transfer harvested list)

– Przenieś pobrane adresy url do listy blogów (Transfer harvested urls to blogs list)

– Przenieś pobrane adresy url do listy stron (Transfer harvested urls to website list) - Wybór danych do komentowania (Post Content)

– Wybór listy imion (słów kluczowych) (Select the „Names” list)

– Wybór listy maili (Select the „Emails” list)

– Wybór listy stron do podlinkowania (Select the „Websites” list)

– Wybór listy komentarzy (Select the „Comments” list)

– Wybór listy blogów (Select the „Blogs” list)

– Eksport poprawnie dodanych komentarzy (Export „success” posts as:) – trzeba jedna pamiętać, że dosyć często ScrapeBox źle interpretuje, kiedy komentarz został dodany poprawnie, a kiedy nie. Tutaj ekportujemy blogi, na których udało się dodać komentarz.

– Eksport źle dodanych komentarzy (Export „failed” posts as:) - Generowanie imion (Generate names)

– Wybór płci: kobieta lub/i mężczyzna (Gender: Female and/or Male) – tutaj zaznaczymy czy chcemy wygenerować imiona tylko kobiecie, męskie czy może oba rodzaje

– Wybór imienia i/lub nazwiska (First Name and/or Last Name) – tutaj zaznaczamy czy chcemy wygenerować tylko imiona i/lub nazwiska

– Ilość generowanych imion (Generate „x” names)

– Zapisanie imion do pliku tekstowego (Save names as:) - Generowanie maili (Generate emails)

– Zawrzyj numery w mailu (Include numbers in emails)

– Zawrzyj liczby na początku maili (Number in front)

– Wybór domeny dla generowanych maili (Domain for emails: @) – tutaj chyba jest jakiś bug, bo można wybrać tylko końcówkę gmail.com

– Ilość generowanych maili (Generate „x” emails)

– Zapisanie maili do pliku tekstowego (Save emails as:) - Harvester komentarzy z adresów URL (Grab comments form harvested urls)

– Pomiń komentarze z linkami w treści (Skip comments with urls)

– Ignoruj komentarze z mniej niż „x” ilością wyrazów (Ignore comments with less than „x” words)

– Zapisanie komentarzy do pliku tekstowego (Save grabbed comments as:) - Dodawanie trackbacków (Post Trackbacks)

- Pingowanie adresów URL (Ping websites)

- Sprawdzanie PageRank (Check PageRank)

– Sprawdź PR dla adresu URL lub dla domeny (Get PR for: URL or Domain)

– Sortowanie adresów względem PR (PR Sort Order: High to Low or Low to High) – wybór sortowania od najwyższego PR do najniższego i vice versa

– Eksport określonych adresów względem PR (Export PR from: „x” to „y”)

– Zapisanie adresów z PR do pliku tekstowego (Save PR as:) - Sprawdzanie linków (Check Links)

– Wybór naszych stron do sprawdzenia (Select the „Websites” list)

– Wybór blogów, w których będą szukane nasze strony z pliku „Websites” (Select the „Blogs” list)

– Zapisz adresy blogów, w których znaleziono link do naszej strony (Save found links list as:)

– Dołącz znalezione linki do innej listy (Append links found to another list:)

– Zapisz adresy blogów, w których pojawił się błąd serwera (Save links reporting server errors as:) - Dodawanie opóźnienia (Wait (add a dalay))

– Ile sekund ? (How many seconds?) – tutaj ustawiamy opóźnienie między zadaniami w sekundach - Importowanie listy adresów do harvestera (Import urls list into harvester gird)

– Podanie ścieżki do importowanego pliku tekstowego (File with urls to import)

– Dołącz adresy URL do harvestera (Append to existing urls in harvester gird)

Do czego można wykorzystać plugin Automator ?

Jedną z głównych rzeczy, które robię w pluginie Automator jest harvestowanie adresów URL. Idealnie ten plugin się do tego nadaje. Najpierw harvestuję proxy i testuję tak, aby nie były zbanowane w Google. Potem wczytuję footprinty i zaczynam harvestowanie z Google. Potem harvestuję nowe proxy i znowu testuję, a następnie zaczynam harvestowanie z Google z ostatniego miesiąca. Ogólnie cały proces jest znacznie rozbudowany i wymagałoby to osobnego wpisu, który zapewne powstanie w dalekiej przyszłości :) Możliwości zastosowania pluginu są ogromne. Na pewno warto wydać 20$. Cena śmieszna jak na takie funkcje.

Brakuje mi tylko w Automatorze funkcji z pluginu ScrapeBox Page Scanner, ale mam nadzieję, że niedługo zostaną one wprowadzone.

(+6, Głosów: 6)

(+6, Głosów: 6)

8 komentarzy

Widzę, że teraz SB rozwija się w jeszcze lepszym kierunku. Ten plugin jest rewelacyjny. Przydałoby się jednak parę rzeczy dorobić żeby plugin stał się jeszcze lepszy.

Dzięki arve_lek za artykuł. Zastanawiałem się czy jest sens kupowania tej wtyczki premium.

plugin wygląda porządnie, działa bez zarzutów ?

Szkoda, że program Ultraseomaster nie zawiera takiego dodatku :)

Działa bez zarzutów.

Tylko czy pomoże mi w zautomatyzowaniu linkowania kilkuset domen? Załóżmy, że utworzę mu 100 plików, w każdym po 6 linijek https://pawelmacur.com/ {słowo|słowo2} i chcę, żeby po zakończeniu komentowania dla jednego pliku zrobił cały rytuał z generowaniem nowych maili, wczytaniem ich, itd., a następnie załadował kolejny plik z linkami do moich stron – da radę coś takiego zrobić?

Nie da się takich rzeczy robić.

Pisałem jakiś czas temu do supportu, żeby dodali pętle + scheduler. Ale pętle czyli powtarzanie całego zadania (z innymi mniejszymi zadaniami) „n” razy w mojej potrzebie będą zupełnie inne niż Twoje. Ja jako przykład podałem zupełnie inny od Twojego. Twórczyni przyznała mi rację, ale w odpowiedzi była obawa właśnie przez takimi osobami jak Ty :) I zapewne powstanie scheduler + pętle, ale będzie zapewne zrobiona jakaś obrona przez tego typu osobami :) Chyba, że nie będzie, ale to trzeba poczekać.

Dlaczego nie było do tej pory zaimplementowanych pętli ? Właśnie między innymi, aby bronić się przed nie zaspamowaniem na potęgę tych samych blogów.

Ale są złe pętle i dobre. Kwestia teraz przemyślenia jak zaimplementować pętlę, aby nikt nie zrobił krzywdy innym.

Złe pętle to np.

Jeżeli pętla będzie dotyczyła harvestowania słów kluczowych, to przy odpaleniu pętli dostaniemy te same słowa kluczowe.

To samo z harvestowaniem adresów url lub proxy.

Support nie odpisał mi stanowczo: Nie takiej funkcji nie wprowadzimy. Ostanie zdanie z maila było w stylu:

„Ale być może w przyszłej aktualizacji będzie coś w stylu pętli, ale tak żeby zapobiegać komentowaniu na te same dane do tych samych blogów”.

Czy da sie importować url-e z pliku textowego bezpośrednio ze strony www a nie dysku lokalnego na komputerze?

nie