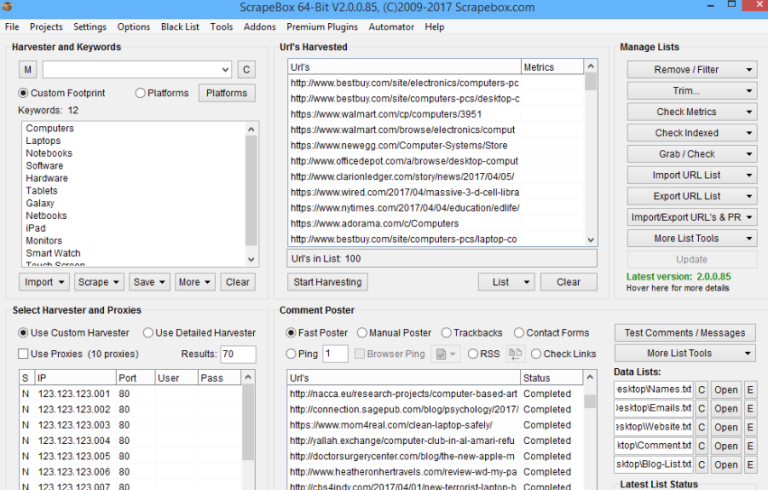

Zainspirowany jednym komentarzem postanowiłem napisać artykuł. Nie będzie on długi, ale pewne sprawy na pewno rozjaśni. Zacznę trochę nietypowo, dlatego, że nie będzie to artykuł o footprintach wyszukujących blogi oparte na różnych platformach itp, a zupełnie o czymś innym, choć powiązanym z harvestowaniem. Dla osób, które nie znają angielskiego, albo znają w stopniu podstawowym powiem, że samo słowo „harvester” oznacza kombajn – nawet w takim jeździłem, ale pewnie dlatego, że mieszkam na wsi :) Komentarz, który spowodował, że postanowiłem napisać ów artykuł brzmi następująco:

Zainspirowany jednym komentarzem postanowiłem napisać artykuł. Nie będzie on długi, ale pewne sprawy na pewno rozjaśni. Zacznę trochę nietypowo, dlatego, że nie będzie to artykuł o footprintach wyszukujących blogi oparte na różnych platformach itp, a zupełnie o czymś innym, choć powiązanym z harvestowaniem. Dla osób, które nie znają angielskiego, albo znają w stopniu podstawowym powiem, że samo słowo „harvester” oznacza kombajn – nawet w takim jeździłem, ale pewnie dlatego, że mieszkam na wsi :) Komentarz, który spowodował, że postanowiłem napisać ów artykuł brzmi następująco:

Fajna wskazówka, ale jak wybierzemy wszystkie platformy do harvestowania, to i tak jest przecież limit w harvesterze 1mln, więc po skończeniu harvestowania nawet jak będzie więcej jak 2mln blogów, to doda nam tylko do boxu 1mln :P Link do komentarza: Marek

W powyższym komentarzu niejaki Marek ma rację, ale nikt nie powiedział, że nie da się tego obejść :D Może nie w takim sensie jak w tej chwili sobie wyobraziłeś/aś, lecz w zupełnie innym. Jak wiadomo podczas harvestowania liczba tych samych adresów jest spora. Niestety gdy podczas harvestowania liczba przekroczy 1mln, to Scrapebox nie usuwa zdublowanych adresów, tylko umieszcza w boxie „Harvested” pierwszy milion. A co z resztą ?

Resztę adresów można znaleźć w folderze: Harvester_Sessions. Potem tylko wystarczy zainstalować wtyczkę Scrapebox DupRemove oraz wczytać pliki z Harvester_Sessions -> Harvester_ostania_data do wtyczki DupRemove i usunąć takie same adresy, albo domeny. Można również najpierw scalić wszystkie pliki, a następnie wczytać scalony plik i usunąć takie same adresy. Potem plik niezawierający zduplikowanych adresów wczytać do Scrapeboxa i tym samym będziemy mieli „więcej jak 1mln” adresów.

(+9, Głosów: 11)

(+9, Głosów: 11)

Jeden komentarz

Daję jeden głos, bo nie wiedziałem, że istnieje folder w którym zapisują się blogi z harvestera. Dzięki wielkie.